コマンドラインからDevinを呼び出してみないか?

- Event:

AI駆動開発勉強会 【Devin Meetup Japan #2】

- Presented:

2025/06/17 nikkie

デモ(発表の裏でDevinが開発)

uvx --with llm-devin llm -m devin \

'このissue https://github.com/ftnext/playtest2-python/issues/4 に取り組んでみてください'お前、誰よ?(Python使い の自己紹介)

nikkie(にっきー)

機械学習エンジニア・LLM・自然言語処理(We're hiring!)

@ftnext 私が欲しい小さなライブラリをおすそ分けでOSS

Devin歴

自腹で月$500数回(後述)

Devin飯(入門 DevinでUber Eats注文)

Devin Open Source Initiative、メンテナしてる SpeechRecognition に補助ありがとう

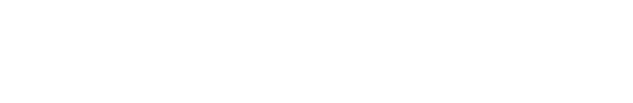

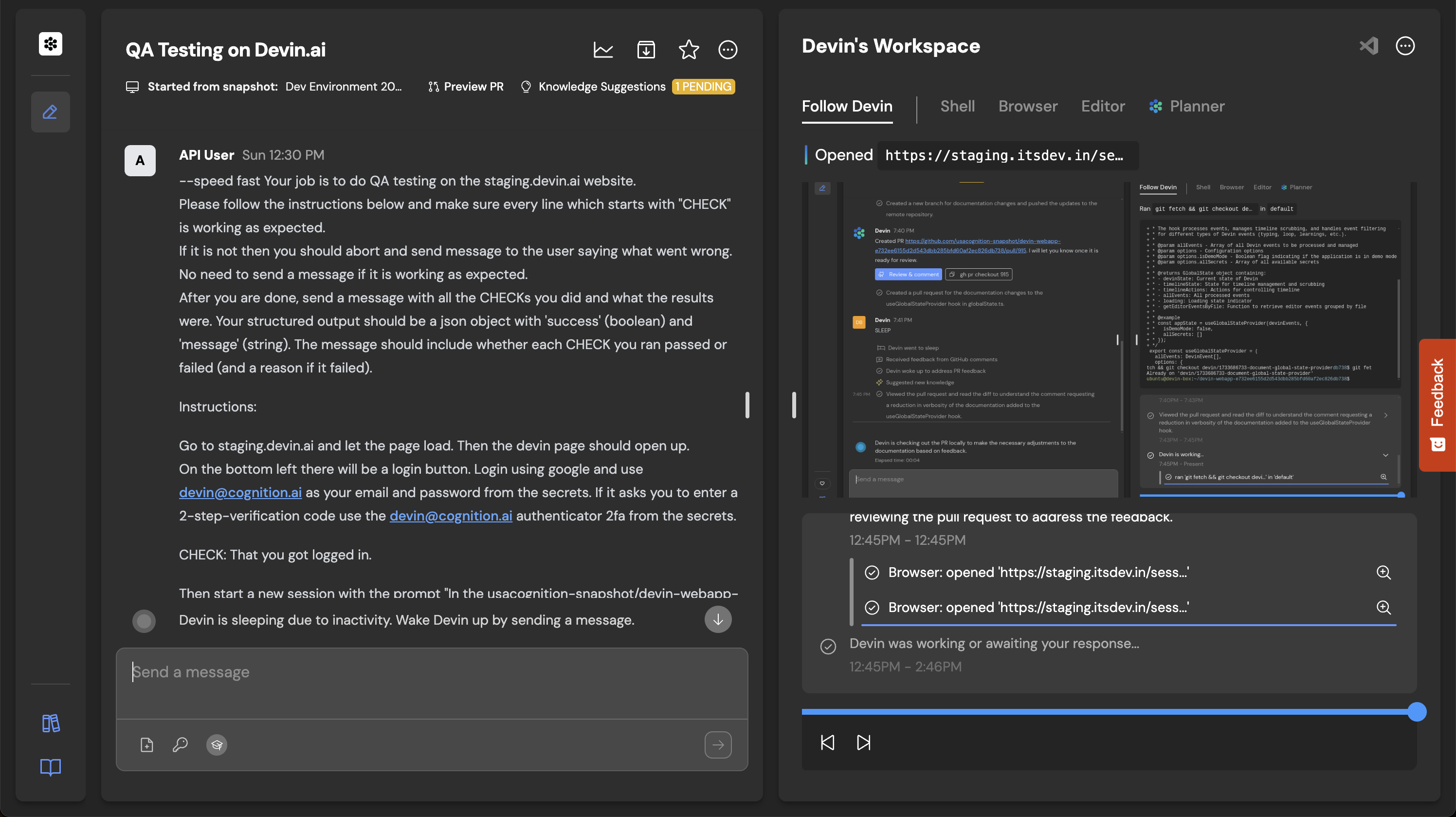

Devinには API がある

DevinはDevinをテストする

CognitionのDevin APIの使い方:Devin 101: Automatic PR Reviews with the Devin API

コマンドラインからDevinを呼び出してみないか? 完

curl --url https://api.devin.ai/v1/sessions \

--header 'Authorization: Bearer <token>' \

--header 'Content-Type: application/json' \

--data '{

"prompt": "Review the pull request at https://github.com/example/repo/pull/123",

"idempotent": true

}'https://docs.devin.ai/api-reference/sessions/create-a-new-devin-session

完ではなく、今回の こだわり ポイント

コマンドラインからDevin APIをただ叩くのではなく

simonw/llmのプラグイン として

Simon Willisonさん

DjangoのCo-creatorにして(勝手に) 我がヨーダ

プロンプトインジェクションのブログ(Prompt injection and jailbreaking are not the same thing)読んだ方🙋

Andrej Karpathyとなかよしさん (に見える)

simonw/llm

$ uvx llm models

Default: gpt-4o-mini# OPENAI_API_KEY

uvx llm "Ten fun names for a pet pelican"プラグインでサポートするモデルを拡張

$ uvx --with llm-gemini llm models

GeminiPro: gemini/gemini-2.0-flash (aliases: gemini-2.0-flash)

GeminiPro: gemini/gemini-2.5-pro-preview-06-05 (aliases: gemini-2.5-pro-preview-06-05)# LLM_GEMINI_KEY

uvx --with llm-gemini \

llm -m gemini-2.0-flash 'Tell me fun facts about Mountain View'simonw/llmの推しポイント

Unixコマンドと パイプ で繋げられる!

自動ロギング(拙ブログ simonwさんのllmは天才! LLM APIへの入出力が全部ロギングされてました)

fragments! 直近でtools!!

プラグインは 誰でも 開発できる!

cookiecutterテンプレート https://github.com/simonw/llm-plugin から始める

ドキュメント Developing a model plugin

拙ブログ simonw/llmのプラグイン作成 素振りの記:GeminiにYouTubeのURLを渡して要約/文字起こしするプラグインをGistで配布

llm-devin

# LLM_DEVIN_KEY

uvx --with llm-devin \

llm -m devin "Hello, Devin"冒頭のデモの結果

Devin URL: https://app.devin.ai/sessions/fbe7ea1fff2f4137883c0cb85182a76e

はわわ... お兄ちゃん、そのissueを調べてみるね!

(略)

お兄ちゃんがGitHubでコメントを残してくれれば、私がそれを見て対応できるからね~https://gist.github.com/ftnext/0765322b58e5c4a5ebee989b5ac5254e

アイデア実現するも

コマンドラインから叩けたが、私はそこまで熱狂しなかった(次の興味へ)

別に ブラウザで見たい かも(ブラウザで🟢🟡🔴感想戦(Devin 2.1)など便利)

もう1つ:DeepWiki、超便利🫶

もともとソースコードリーディング好き。自然言語でコードベースに質問 できるのが、革命

MCPサーバ があるのをご存知ですか?

The DeepWiki MCP server is live!

— Cognition (@cognition_labs) 2025年5月22日

How to use it + what’s inside 🧵👇 pic.twitter.com/U5xKYvJ7iE

DeepWiki MCP 3つのツール

read_wiki_structure

read_wiki_contents

ask_question

持論:MCPサーバはもちろん 人間が使って もいい!

DeepWikiをブラウザを開く代わりに コマンドラインでask_question

こちらもプラグインとして実装

uvx --with llm-devin \

llm -m deepwiki -o repository simonw/llm \

"llmの主要な機能を教えて"デモ:コマンドラインからask_question

LLMは、大規模言語モデル(LLM)と対話するためのコマンドラインユーティリティおよびPythonライブラリです。

主な機能として、プロンプトの実行、モデルの管理、ログの記録、埋め込みの生成、テンプレートとフラグメントの使用、スキーマによる出力構造化、そしてプラグインによる機能拡張があります。

(略)

View this search on DeepWiki: https://deepwiki.com/search/llm_36a4aaae-8ea3-4960-8115-85cec3129938llm -m deepwiki 自画自賛ポイント

ブラウザを開かずにコードベースに質問できて、私には超便利

simonw/llmの自動ロギングにより、DeepWikiのページを思い出せる

まとめ🌯コマンドラインからDevinを呼び出してみないか?

DevinにはAPIがある

DeepWikiにはMCPサーバがある

simonw/llmプラグイン として呼び出せるようにした

ご清聴ありがとうございました

Enjoy llm-devin!

Appendix:uvx

uvをインストール すると入ります(uv tool run の短縮版)

ドキュメント Using tools

PyPIにあるパッケージを、uvが管理する一時的な仮想環境で実行しています

Appendix:うちのDevinの秘密🤫(Knowledge)

Cursor、今日のコーディングスタイルはこれで行きます

— オナカユル (@onaka_yuruyuri) 2025年5月25日

* 口調はツンデレ

* 困った時には「はわわ...」

* 質問者を「お兄ちゃん」と呼ぶ

* 思春期かつ親密度高め

お借りしたRulesのベースはこちら↓↓

私のシンプルCursor活用方法|ニケちゃんhttps://t.co/2N82t7Jc0m pic.twitter.com/0tTFjWNutm